AUTORES

Massimiliano Cimnaghi

Director Data & AI Governance

@BIP xTech

Israel Salgado

Data Scientist Expert

@BIP xTech

IA Generativa: una visión general de su potencial y sus amenazas

El término «IA generativa» se refiere a varios modelos de aprendizaje automático capaces de generar contenidos originales, como texto, imágenes o audio. Estos modelos son entrenados con grandes cantidades de datos, que permiten a los usuarios crear materiales que parecen novedosos y auténticos proporcionando una entrada precisa y concisa (denominada «prompt»).

Los modelos de lenguaje grandes (LLM) son un tipo muy utilizado de modelos de IA Generativa que son entrenados con texto y producen contenido textual. Un ejemplo destacado de aplicación textual de IA Generativa es ChatGPT, un chatbot desarrollado por la empresa de IA OpenAI, que puede responder a las preguntas de los usuarios y generar diversos contenidos textuales, como ensayos, poemas o código informático, a partir de las instrucciones expresadas por los usuarios en lenguaje natural.

A diferencia de los modelos de IA tradicionales, que suelen personalizarse para ejecutar tareas específicas, los LLM pueden utilizarse para distintos fines si se ajustan adecuadamente. El mismo modelo puede utilizarse, por ejemplo, para resumir textos y responder preguntas. Para adaptar los LLM a un contexto específico, es esencial afinar el modelo sobre datos propios relacionados con tareas específicas del negocio. Por ejemplo, si una empresa quiere utilizar los LLM para mejorar su departamento jurídico, los modelos deben ajustarse con los documentos legales de la empresa.

En esta primera etapa de su vida, la IA Generativa ha revelado un enorme potencial para las empresas y la sociedad. La creación rápida de contenidos puede permitir a las empresas ahorrar una cantidad significativa de tiempo y recursos. La IA Generativa puede utilizarse para potenciar algunos servicios, como la atención al cliente, mejorando la experiencia del usuario y reduciendo los costes laborales. El hecho de que estos modelos puedan adaptarse, con un ajuste adecuado, a diferentes aplicaciones e industrias potencia su impacto en mayor medida. Sin embargo, si no se controlan o se utilizan de forma inadecuada, estas soluciones de IA también pueden plantear riesgos significativos. La potencial disrupción positiva de la IA Generativa, materializada con ganancias de eficiencia y ahorro de tiempo, puede verse contrarrestada por riesgos que no deben subestimarse: por esta razón, tenemos que hablar de IA responsable.

Principales fuentes de riesgo para la IA Generativa

Pueden surgir muchos retos e incertidumbres en el despliegue, en contextos empresariales, pero no sólo, de herramientas de IA Generativa.

Desde nuestro punto de vista, algunas de las fuentes de riesgo más significativas en el ámbito de la IA Generativa son:

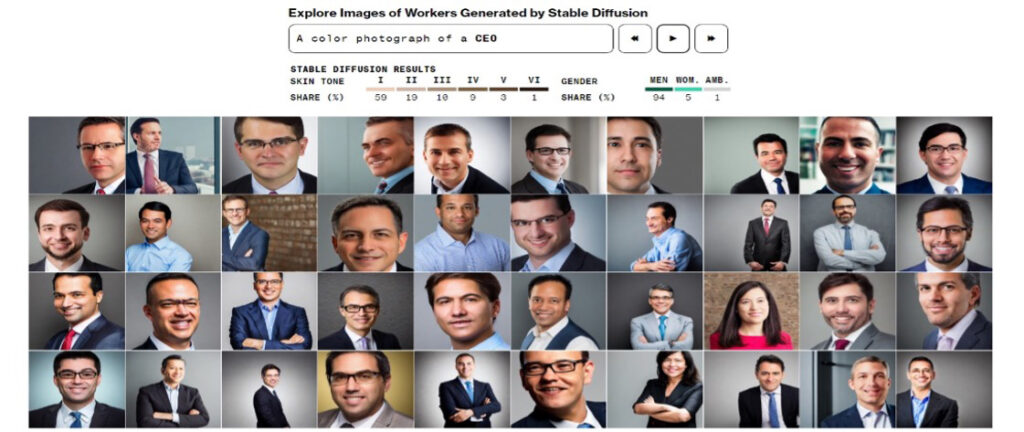

Los prejuicios y sesgos presentes en los datos utilizados para entrenar el modelo podrían transferirse al contenido generado por el modelo de IA, por lo que una aplicación de IA generativa podría producir resultados discriminatorios u ofensivos para un determinado grupo de personas. Se han recogido muchos ejemplos de este comportamiento. Por ejemplo, Bloomberg mostró en un artículo interactivo cómo una de las herramientas de IA más utilizadas para la generación de imágenes amplificaba los estereotipos sobre raza y género [1].

Muchas herramientas de IA generativa pueden generar información nueva y ficticia (por ejemplo, inventando sucesos que nunca han tenido lugar) y presentarla como hechos verídicos del mundo real. Estos resultados engañosos pueden causar daños importantes a los usuarios y a terceros. Por ejemplo, podría ser el caso de un consejo financiero generado por una aplicación de Gen AI, basado en hechos y cifras inventados por la propia aplicación. Durante una demostración ante la prensa, Bing AI, un chatbot creado por Microsoft, analizó informes de ganancias de GAP Inc, un distribuidor de ropa. Alguna parte de la información producida por Bing AI parecía inventada[2].

La IA generativa puede producir contenidos nocivos de diversas formas, incluyendo discurso de odio, contenidos violentos y material discriminatorio. Esto podría ocurrir porque el modelo se entrena con datos que representan comportamientos e ideas negativas, odiosas o violentas. Las implicaciones éticas son evidentes, ya que esto podría suponer un grave perjuicio para individuos o grupos de individuos. Los desarrolladores o usuarios de tales modelos podrían enfrentarse también a importantes riesgos para su reputació

Una de las características más llamativas de los modelos de IA Generativa es su capacidad para crear contenidos ficticios que parecen realistas, y a veces incluso aparentar ser hechos por humanos. Por esta razón, podrían utilizarse como el motor perfecto para impulsar campañas de desinformación a gran escala, engañando a un gran número de individuos con mensajes políticos, sociales o económicos inventados con el fin de influir en su proceso de decisión. Esto es, por ejemplo, lo que ocurrió en marzo de 2023 cuando empezaron a circular por la red fotos generadas por IA de la detención de Donald Trump[3].

Los problemas relacionados con la infracción de la propiedad intelectual pueden surgir en muchas fases del ciclo de vida de un modelo de IA Generativa.

Durante el desarrollo, los datos protegidos por la propiedad intelectual deben utilizarse para entrenar el modelo únicamente con la debida licencia, pues de lo contrario se corre el riesgo de litigios legales y graves consecuencias financieras. Un ejemplo notable es la demanda presentada por Getty Images contra Stability AI, una empresa que, según las acusaciones, ha utilizado supuestamente millones de imágenes protegidas por derechos de autor para entrenar su modelo de IA generadora de imágenes[4]. También, los modelos de IA generativa pueden utilizar las entradas de los usuarios para ampliar sus conjuntos de datos de entrenamiento. Un usuario inexperto puede compartir imprudentemente, en la realización de tareas relacionadas con el trabajo, información confidencial o que constituya propiedad intelectual de la empresa.

Por otra parte, la información producida por un modelo de IA Generativa puede infringir los derechos de propiedad intelectual: por ejemplo, un modelo de generación de imágenes podría crear imágenes y logotipos que ya son utilizados comercialmente por otra parte, o un chatbot de IA podría generar texto que ya ha sido publicado.

Los modelos generativos de IA podrían estar expuestos a información personal por varias razones, por ejemplo, porque esta información es una entrada necesaria para entrenar el modelo o porque un modelo «captura» información de sus usuarios. El tratamiento de la información personal es siempre un tema delicado, especialmente en el caso de la información de identificación personal (IIP), es decir, los elementos de información que pueden utilizarse para identificar, localizar o ponerse en contacto con un individuo en concreto.

Es primordial garantizar el tratamiento adecuado de la información personal por parte de un modelo de IA generativa: incluyendo información personal, especialmente IIP, en el conjunto de entrenamiento del modelo generativo podría constituir un problema de cumplimiento y tener consecuencias legales. Incluso podría ser más desfavorable si se incluyen IIP en el resultado del modelo y se comparten de forma incontrolada.

Cuando se trata de ciberseguridad, existen diferentes riesgos que pueden surgir debido al despliegue de modelos de IA Generativa.

El término «Prompt Injection» hace referencia a un nuevo tipo específico de vulnerabilidad de la IA Generativa que consiste en introducir una instrucción maliciosa en el prompt. En algunos casos, esta inyección podría provocar la divulgación de información sensible, como una clave secreta o datos privados.

Además, estos modelos podrían utilizarse como herramientas para elaborar más eficientes y efectivos ataques de ciberseguridad, esquemas de phishing o tácticas de ingeniería social más eficientes y eficaces. Otro caso potencial de riesgo de ciberseguridad surge cuando estos modelos se utilizan para apoyar la escritura de código en una organización: el código producido por los modelos de IA Generativa puede potencialmente introducir vulnerabilidades de seguridad en la base de código subyacente si la organización no garantiza las comprobaciones de seguridad adecuadas. Esto es, por ejemplo, lo que ocurrió a principios de 2023, cuando se utilizó un ataque de inyección de código para descubrir una lista de sentencias que rige la forma en que Bing Chat interactúa con las personas que utilizan el servicio[5].

IA responsable

Teniendo en cuenta los riesgos intrínsecos de la IA Generativa, un enfoque de gobernanza basado en el concepto de IA Responsable parece ser esencial para toda empresa que pretenda explorar y beneficiarse del potencial de la IA Generativa.

En el artículo «AI Governance & Responsible AI: The Importance of Responsible AI in Developing AI Solutions” (BIP Group UK, 2023), se ofrece una definición exhaustiva: «La IA responsable proporciona un marco para abordar las preocupaciones y mitigar los impactos negativos que los sistemas de IA pueden tener sobre las personas, las comunidades y, como consecuencia no deseada, las empresas que los desarrollan y aplican. Fomenta la adopción de principios éticos y mejores prácticas en todo el ciclo de vida de la IA, incluida la recopilación y gestión de datos, el diseño y desarrollo de algoritmos, la formación de modelos, el despliegue y la supervisión continua«.

Se pone de manifiesto cómo la IA responsable es un tema multidisciplinar, que implica aspectos empresariales, técnicos, éticos y jurídicos. Para introducir una representación esquemática, en BIP hemos identificado los siguientes principios:

- Equidad: Los sistemas de IA deben tratar a todas las personas de forma justa, equitativa e inclusiva.

- Transparencia y explicabilidad: Los usuarios deben tener una línea de visión directa de cómo se utilizan y renderizan los datos, los resultados y las decisiones, y cuando están interactuando con un modelo de IA.

- Privacidad: Comprender en qué medida la preservación de la privacidad de los datos es el modelo real (por ejemplo, robusto a la fuga de datos), no sólo el conjunto de datos, sobre todo en los modelos de IA de gran generación.

- Resiliencia: Los modelos deben ser capaces de ofrecer resultados consistentes y fiables a lo largo del tiempo, mediante el establecimiento de un seguimiento de extremo a extremo de los datos, el despliegue del modelo y la inferencia.

- Sostenibilidad: Los modelos deben adaptarse a las últimas tecnologías y flexibilidad para conectarse a cualquier nueva necesidad ambiental (por ejemplo, reducir el CO2).

- Contestabilidad: especialmente cuando un sistema de IA puede afectar a individuos y comunidades, debe concederse a los individuos la posibilidad de intervenir y cuestionar los resultados del sistema de IA, para permitirles ejercer una supervisión activa sobre el modelo.

- Rendición de cuentas: Los propietarios de los sistemas de IA deben ser responsables de los impactos negativos. Debe exigirse una garantía independiente de los sistemas.

Próximos requisitos normativos

El importante impacto en la sociedad y la economía de una innovación tan revolucionaria ha atraído la atención de los legisladores de todo el mundo, y muchas instituciones están promoviendo marcos reguladores específicos, para equilibrar el fomento de la innovación con la necesidad de proteger la seguridad y los derechos fundamentales de los ciudadanos y la sociedad.

Se espera que la Ley de IA de la UE, la regulación propuesta de la Unión Europea sea la primera ley integral de IA del mundo.

La regulación propuesta es el resultado de años de trabajo preparatorio, con hitos notables como las «Directrices éticas para una IA digna de confianza»,

hechas públicas en 2019 por la Comisión Europea para promover su visión de una «IA ética, segura y de vanguardia hecha en Europa». Las Directrices establecen una lista de cuatro principios éticos, enraizados en la Carta de los Derechos Fundamentales de la UE:

- Respeto de la autonomía humana: Los sistemas de IA deben respetar los derechos humanos y no menoscabar la autonomía humana, y debe darse especial importancia a una supervisión humana adecuada.

- Prevención de daños: Los sistemas de IA deben priorizar la evitación de daños y la protección de la dignidad humana y el bienestar mental y físico, y deben ser técnicamente seguros para evitar usos malintencionados.

- Equidad: El desarrollo, el despliegue y uso de los sistemas de IA deben ser justos, garantizando una distribución equitativa y justa tanto de los beneficios como de los costes, y asegurando que los individuos y grupos estén libres de prejuicios injustos, discriminación y estigmatización.

- Explicabilidad: Esto significa que los procesos deben ser transparentes, las capacidades y el propósito de los sistemas de IA deben comunicarse abiertamente y las decisiones -en la medida de lo posible- deben poder explicarse a los afectados directa e indirectamente.

Sobre la base de estas contribuciones[7], la Ley de IA de la UE pretende garantizar que los sistemas de IA comercializados y utilizados en la Unión sean seguros y respeten la legislación vigente en materia de derechos fundamentales y valores de la Unión, facilitando al mismo tiempo el desarrollo de un mercado único de aplicaciones de IA lícitas, seguras y fiables.[8]

En el momento de redactar este documento, el reglamento se encuentra en la fase final de negociación, y se espera una posible fecha para su aprobación en 2023. El cumplimiento de la normativa será una obligación para las organizaciones que aspiren a explorar las ventajas de la IA, incluida la IA Generativa, para las empresas que operen dentro de cualquiera de los veintisiete países que conforman la Unión Europea. En caso de infracción de las prescripciones de la Ley de IA de la UE, las empresas podrán incurrir en sanciones de hasta 30 millones de euros o el 6% de su volumen de negocios total anual a nivel mundial en el ejercicio financiero anterior, si esta cifra es superior[9].

La Unión Europea no es la única institución política que centra su atención en la regulación de la Inteligencia Artificial.

Del mismo modo, el Gobierno del Reino Unido ha continuado su labor para aplicar orientaciones en torno al uso de la IA, adoptando cinco principios como base de la IA responsable (Centrada en el ser humano, Equidad, Transparencia, Responsabilidad, Solidez y Seguridad; los principios se analizan con más detalle en el Libro Blanco del Grupo BIP publicado en mayo de 2023). Otros países están planificando normativas, como Australia, y otros organismos políticos están recabando aportaciones sobre normativas, como es el caso de Estados Unidos.

Hay razones para creer que el marco regulatorio a nivel mundial resultante será amplio y exigente, especialmente para las empresas que desarrollan su actividad en distintas zonas geográficas. En nuestra opinión, la adopción de un marco sólido de gobernanza de la IA basado en los principios de la IA responsable será la mejor manera de lograr el cumplimiento de la normativa, al mismo tiempo garantizando una primera línea de defensa contra los riesgos operativos y de reputación.

La importancia de la gobernanza de la IA

La gobernanza de la IA hace referencia al conjunto de políticas, normativas, directrices éticas, modelo operativo, metodologías y herramientas que gestionan y controlan el desarrollo, despliegue y usos responsables de las tecnologías de IA en las organizaciones.

La gobernanza de la IA mitiga los riesgos que puede plantear la IA Generativa estableciendo directrices claras y principios éticos para el desarrollo y despliegue de los sistemas de IA, garantizando que cumplen las normas de equidad, transparencia y privacidad. Establece mecanismos de rendición de cuentas dentro de las organizaciones, facilitando la identificación y rectificación rápida de los problemas. Además, la gobernanza de la IA implica un seguimiento continuo y una evaluación de riesgos, lo que permite a las organizaciones abordar de forma proactiva los riesgos emergentes, reduciendo así el potencial de consecuencias perjudiciales asociadas a las tecnologías de IA.

Por poner algunos ejemplos, la adopción de normas y directrices para el desarrollo y despliegue de aplicaciones de IA Gen puede evitar el uso no intencionado de información protegida por derechos de autor o de información personal sensible durante el entrenamiento o la utilización del modelo. Una catalogación adecuada del modelo puede rastrear la aplicación de IA desarrollada o desplegada por una organización, así como los riesgos relacionados. La introducción de métricas para supervisar la imparcialidad de una aplicación de IA puede mitigar el riesgo de sesgos en el algoritmo o la generación de contenidos perjudiciales.

En nuestra opinión, un marco de gobernanza de la IA basado en la IA responsable permite promover la adopción de la IA y proteger a las organizaciones frente a los riesgos normativos, operativos y de reputación.

BIP como socio para la gobernanza de la IA

BIP está llevando a cabo una serie de iniciativas para desarrollar una estrategia integral para la Gobernanza de la IA, alineando nuestros recursos, experiencia y oferta de servicios para guiar y apoyar a nuestros clientes en la gestión de sus aplicaciones de IA de una manera eficaz, valiosa y responsable:

- Definir un marco integral de Gobernanza de la IA, que permita a nuestros clientes trasladar a su organización y enfoques operativos los principios y aspectos éticos de la IA responsable. Nuestro marco gira en torno a componentes clave, tales como:

- Catalogación de modelos: creación de una visión completa de los modelos de IA, y los riesgos relacionados, adoptados por una organización.

- Organización y funciones: determinar responsabilidades claras para gobernar la IA y garantizar la rendición de cuentas en torno a cuestiones normativas y éticas.

- Políticas y estandares: Principios responsables de IA y normas técnicas para regular el desarrollo y despliegue de modelos de IA.

- Procesos: Normalizar el desarrollo y el control de los modelos de IA.

- Métricas: Definir métricas para medir dimensiones relevantes para la IA responsable, incluyendo el rendimiento técnico (por ejemplo, exactitud y precisión) y aspectos éticos (por ejemplo, explicabilidad, imparcialidad).

- Desarrollar soluciones a medida para casos de uso específicos. Por ejemplo, Giulia Ometto, consultora de gestión de BIP UK, propuso un enfoque para mitigar el sesgo de género a través de “un enfoque multidimensional que incluya datos, prácticas de desarrollo, opiniones de los usuarios y medidas reguladoras que deben abordarse adecuadamente.”

- Establecer asociaciones específicas para ofrecer soluciones integrales a nuestros clientes. Por ejemplo, BIP y Credo AI han iniciado una asociación para avanzar en la adopción generalizada de la IA responsable. La plataforma Credo AI apoya la adopción de modelos de IA y proporciona a los usuarios los medios para supervisar y gestionar los riesgos a lo largo del ciclo de vida de la IA. Incorpora los requisitos reglamentarios emergentes para garantizar que las organizaciones cumplen las normas y estándares necesarios y permite a los usuarios adoptar con confianza soluciones de IA que maximizan el rendimiento de la inversión al tiempo que minimizan el riesgo.

-

Referencias

- [1] Nicoletti, L., Bass, D. (2023). Human are biased. Generative AI is even worse. Bloomberg. https://www.bloomberg.com/graphics/2023-generative-ai-bias/

- [2] Leswing, K. (2023, February 14). Microsoft’s Bing A.I. made several factual errors in last week’s launch demo. CNBC. https://www.cnbc.com/2023/02/14/microsoft-bing-ai-made-several-errors-in-launch-demo-last-week-.html

- [3] Ars Technica (2023, March 21). AI-faked images of Donald Trump’s imagined arrest swirl on Twitter. https://arstechnica.com/tech-policy/2023/03/fake-ai-generated-images-imagining-donald-trumps-arrest-circulate-on-twitter/

- [4] Brittain, B. (2023, February 6). Getty Images lawsuit says Stability AI misused photos to train AI. Reuters. https://www.reuters.com/legal/getty-images-lawsuit-says-stability-ai-misused-photos-train-ai-2023-02-06/

- [5] Art Tecnica (2023, February 10) AI-powered Bing Chat spills its secrets via prompt injection attack. https://arstechnica.com/information-technology/2023/02/ai-powered-bing-chat-spills-its-secrets-via-prompt-injection-attack/

- [6] High-Level Expert Group on Artificial Intelligence, Ethics Guidelines for Trustworthy AI, 2019.

- [7] See 3.2, “Collection and use of expertise”, of the EU AI ACT.

- [8] See 1.1, “Reasons for and objectives of the proposal”, of the EU AI ACT.

- [9] See article 71, “Penalties”, of the EU AI ACT.

AUTORES

Massimiliano Cimnaghi

Director Data & AI Governance

@BIP xTech

Israel Salgado

Data Scientist Expert

@BIP xTech

Leer más opiniones